Die Sache mit den Sensoren

Es ist schon erstaunlich, wie allerorten 4 K fähige Kameras auf den Markt kommen, kaum dass die Industrie durch neue Standards neue Kaufanreize schaffen will. Da werden uns ständig Höchstauflösungen vor die Augen geworfen, die wir ehrfürchtig als Verbesserungen feiern.

Dabei sind es oft nur Halbwahrheiten oder gar Marketing-Schwindeleien, die uns zu Begeisterungsstürmen oder Kaufaktionen bewegen. Wie viele der Pixel sind denn tatsächlich bildgebend?

Pixel-Schiebereien

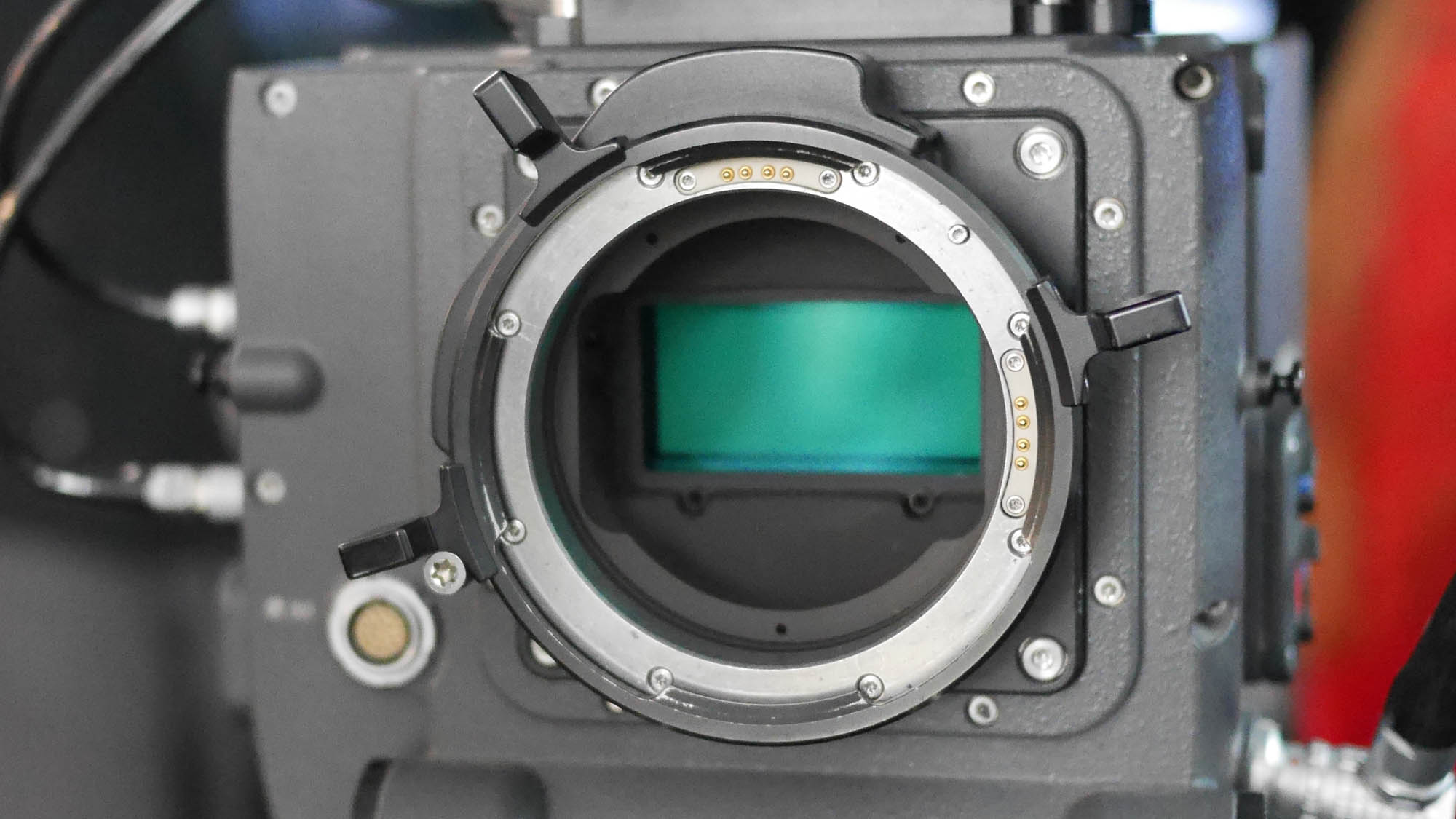

Einzelne lichtempfindliche Dioden im Sensor, neudeutsch auch Sensel genannt, können eigentlich nur Helligkeiten messen. Indem man sie mit einem Farbfilter (zumeist RGB, selten YCM) versieht, können Sie die Helligkeit im entsprechenden Farbbereich messen. Da unsere Bildwiedergabesysteme mehrheitlich nach der additiven Farbmischung, also dem RGB Prinzip arbeiten, werden die Filter vor den Photodioden entsprechend verteilt.

Haben wir es mit einer Ein-Chip Kamera zu tun, so befinden sich auf dem Sensor lichtempfindliche Dioden mit roten, grünen oder blauen Filtern. Weil das menschliche Auge, vermutlich eine Folge der Evolutionsgeschichte des Menschen, im Bereich Grün besonders sensibel ist, sind die grün sensibilisierten Dioden sogar doppelt so oft vorhanden, wie die roten und die blauen.

Man darf sich das nun nicht so vorstellen, als würde vor jede Photodiode ein winziger Glasfilter aufgeklebt. Das geschieht übrigens im Druckverfahren, je nach Bayer-Pattern werden unterschiedliche Verteilungen von Filterfarben auf die Dioden aufgebracht.

Unterschiedliche Annäherungen an den analogen Filmlook

Manche Hersteller weichen von der üblichen Verteilung RGGB, ab. Der japanische Konzern Fuji etwa hat für viele seiner teureren APS-C (=Super 35) Fotoapparate Sensoren nach dem sogenannten X-Trans Prinzip für die Farben sensibilisiert und so im Grünbereich noch mehr Sensibilisierung (dafür im Rot und Blau etwas weniger Sensibilisierung) und eine organischere Farbverteilung erzielt.

Aber an dem rechnerischen Problem ändert das wenig. Werden die Daten in RAW aufgezeichnet, verlagert man die Auswertung (das De-Bayering) in die Postproduktion, wo mit entsprechenden Programmen, wie DaVinchi dann der genaue Look erzeugt wird.

Wieviel K darf´s denn sein?

Auf einem Sensor, der beispielsweise 4K Auflösung verspricht, steht diese Auflösung deshalb gar nicht zur Verfügung, sie müsste streng genommen, durch vier oder drei geteilt werden. Doch das würde die Auflösung drastisch schrumpfen lassen. Um das zu verhindern, wird versucht durch geschickte Algorithmen, die jeweiligen Farbanteile der Nachbardioden zu schätzen. Der Verlust fällt dadurch nicht ganz so hoch aus. Es gibt allerdings auch Fälle, wie bei den Canon Profi-Videokameras, wo man, wenn man dies so im Menü einstellt, tatsächlich aus den Diodenquadraten mit den vier RGGB Informationen lediglich die Info für einen einzelnen Pixel im Bildsignal generiert und dadurch aus dem 4 K Sensor ein sehr gutes HD (1920 × 1080 Pixel) Signal erzeugt.

Einen anderen Weg wählte Sigma, die für ihre Fotoapparate den so genannten Foveon Sensor entwickelten, bei dem die jeweiligen farbsensiblen Dioden in Schichten übereinander angeordnet sind. (Dieses Prinzip ähnelt dem der früheren farbsensibilisierten Schichten im analogen Farbfilm.) Dadurch kann quasi jeder Pixel gleichzeitig auf alle drei Farbanteile hin ausgemessen werden. Es hat aber den Nachteil, dass die rote, zu unterst liegende Schicht nur noch das Licht abbekommt, was durch die darüber liegenden noch nicht weggenommen wurde.

Mehr bringt Mehr

Aus diesen Gründen kann man aus einem 4K Sensor einfach kein perfektes 4K Bild herstellen. Der ein-Chip Sensor muss eine höhere Auflösung mitbringen, um daraus durch das Herunterrechnen (Downscaling) ein sauberes 4K Signal bereitstellen zu können. Das erhöht auch die Ansprüche an die Rechenleistung der Kamera und den Sensor, der eine noch höhere Pixelzahl auslesen muss.

Im Videobereich geht Blackmagic etwas in diese Richtung, indem sie die URSA auch mit einem 4,6 K Sensor anbietet, RED mit ihrer Raven in 4,5 K oder die Sony A7R II Mirrorless wo ein 5K Sensor verwendet wird um ein 4K Bild hochwertig auszulesen.

Nicht ganz verschwiegen werden darf ein kleiner Nachteil der hohen Pixeldichte: Die Fläche der einzelnen Fotodioden wird kleiner und der Sensor dadurch unempfindlicher. Das verstärkt das Rauschen in den Aufnahmen, welches die Hersteller wieder durch unterschiedliche Methoden zu reduzieren versuchen. Oft sind die Kompensationsmethoden zum Nachteil für die Bildqualität, hochwertige Profikameras die mit hohen Datenraten das Signal aufzeichnen, greifen eher weniger ein.

Die reinen Pixelwerte einer Kamera sagen also nicht zwingend etwas über die Güte des Bildes aus, 4K ist eben nicht gleich 4K, selbst wenn der Aufkleber auf dem Karton noch so hübsch glitzert...